앞서 Google이 개발한 TCP BBR 혼잡제어 알고리즘에 대해서 간단하게 포스팅했으니 바로 TCP BBR 적용을 해보도록 하겠습니다.

제한사항

Linux 커널 4.9버전이상에서 사용 가능.

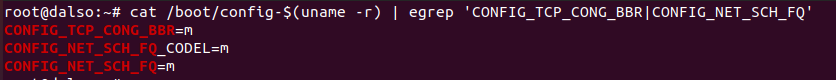

리눅스 커널에 모듈로 내장된 옵션 확인

CONFIG_TCP_CONG_BBR

CONFIG_NET_SCH_FQ

cat /boot/config-$(uname -r) | egrep 'CONFIG_TCP_CONG_BBR|CONFIG_NET_SCH_FQ'

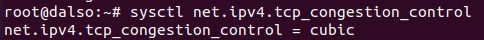

기존 설정 확인(cubic)sysctl net.ipv4.tcp_congestion_control

TCP BBR 적용하기

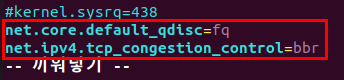

먼저 /etc/sysctl.conf 파일 수정을 해야합니다.vi /etc/sysctl.conf

맨아래로 내려가서 두줄을 추가시켜줍시다.net.core.default_qdisc=fq

net.ipv4.tcp_congestion_control=bbr

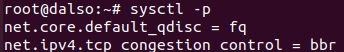

작성이 완료되었으면 sysctl -p 명령어로 적용해줍니다.

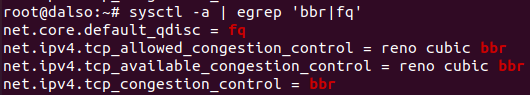

적용 확인

sysctl -a | egrep 'bbr|fq'

이거는 esxi에서 돌아가는 vm들에게도 적용시킬 수 있을까요?

esxi 설정 보면 스위치 설정이었나 설정 페이지에서 CUBIC 라는 제어가 기본옵션으로 보이고

bbr옵션은 안보이더라구요.

그런 것과 무관하게 일반 iptime 공유기 esxi 서버등에서 tcp bbr 적용이 가능할까요?

일반 esxi vm에도 적용 가능합니다. 리눅스 커널단에서 처리하는 네트워크 tcp 처리방식을 변경하는거라 실제 vm에서 처리하는속도도 증가되는걸로 알고있어요