안녕하세요. 달소입니다.

오늘은 사이트 운영을 하면서 필수적으로 해야할 설정인 악성/스팸 봇을 차단하는 방법입니다.

대계 사이트를 운영하는경우 웹에 노출되기때문에 robot.txt를 통해 크롤링을 허용하고 계실텐데요. 이중에서는 검색에 도움은 되지않고 사이트의 트래픽을 낭비하거나 정보를 긁어가는 크롤링도 빈번하게 일어납니다.

그렇기 때문에 관리자로써 불필요하다고 생각되는 봇들은 차단하는게 좋습니다.

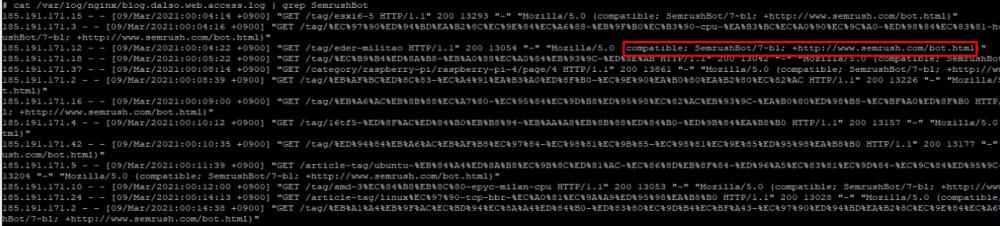

대표적은 악성봇으로는 SemrushBot이 있는데요. 아마 Nginx의 로그를 보시면 아래처럼 185.191.171.0 대역대를 통해 지속적으로 사이트에 접근하는걸 확인할 수 있습니다.

이외에 제가 악성봇이라고 판단하는것들은 AhrefsBot|BLEXBot|DotBot|SemrushBot|Eyeotabot|PetalBot|MJ12bot|brands-bot|bbot|AhrefsBo|MegaIndex|UCBrowser|Mb2345Browser|MicroMessenger|LieBaoFast|Headless|netEstate|newspaper|Adsbot/3.1|WordPress/|ltx71 이며 추가적으로 차단하고싶으시다면 코드에도 조금만 수정해주시면 손쉽게 수정가능합니다.

nginx 설정하기

설정파일은 /etc/nginx/sites-available/[도메인] 의 server { 아래 아래와같은 내용을 추가해주시면 됩니다.

### 공백 UserAgent 차단

if ($http_user_agent = “”) {

return 403;

}

### 기타 불필요한 스팸,악성 봇 차단

if ($http_user_agent ~* (AhrefsBot|BLEXBot|DotBot|SemrushBot|Eyeotabot|PetalBot|MJ12bot|brands-bot|bbot|AhrefsBo|MegaIndex|UCBrowser|Mb2345Browser|MicroMessenger|LieBaoFast|Headless|netEstate|newspaper|Adsbot/3.1|WordPress/|ltx71) ) {

return 403;

}

이렇게 설정해준뒤 service nginx restart로 서비스를 재시작 시켜주면 됩니다.

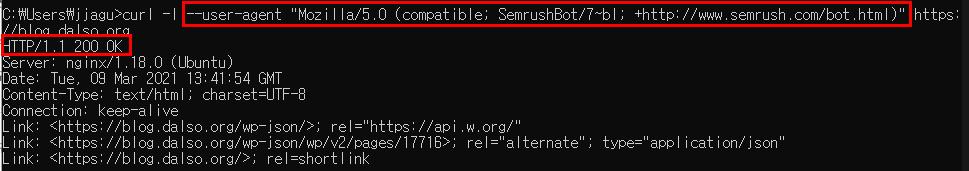

테스트

설정전 curl로 user-agent를 변경해서 테스트했습니다.

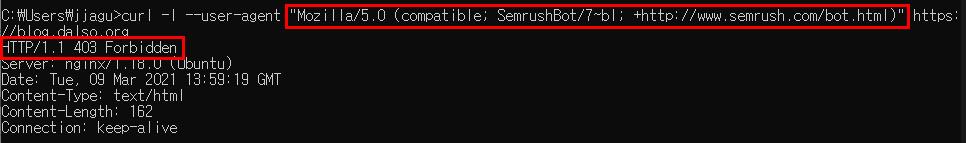

SemrushBot 차단 설정 후 다시 테스트 결과입니다.

모두둘 사이트 트래픽을 아껴주세요~ ㅎㅎ